최근에 연구실에서 사용할 Cuda 를 찾아보다가, 최신 버전인 9.0을 설치하였고, cuDNN 7.0을 설치하였다.

그런데 위의 버전들은 torch 와 pytorch를 지원해주지 않는 것을 확인했다.

나는 tensorflow를 써서 상관이 없지만... 어쨋든 모두가 써야 하는 것이기에

cuda 8.0 버전을 설치하려고 nvidia developer 공식 사이트에 가보았지만 찾기가 힘들었다.

결국 구글링 끝에 주소를 찾았다...

https://developer.nvidia.com/cuda-toolkit-archive

cuDNN 예전 버전은 다음 사이트에서 받으면 된다.

(로그인이 필요함)

https://developer.nvidia.com/rdp/cudnn-download

cuda 9.0 과 cuDNN 7.0을 그대로 둔 상태에서 설치를 진행 할 것이다.

문제가 된다면 다음의 명령어를 통해 cuda 9.0 버전을 삭제하려고 한다.

$ sudo /usr/local/cuda-9.0/bin/uninstall_cuda_9.0.pl

$ sudo /usr/bin/nvidia-uninstallTo enable the Nouveau drivers, remove the blacklist file created in the Disabling Nouveau section, and regenerate the kernel initramfs/initrd again as described in that section.

아직 9.0 출시가 얼마 않되어 프레임워크 지원이 완벽하지 않은 것 같다...

'딥러닝 > CUDA' 카테고리의 다른 글

| cuda 10.0, 9.0 가장 간단하게 설치 (0) | 2019.10.07 |

|---|---|

| Tensorflow 이용 후 cuDNN 초기화 및 GPU에 garbage메모리 있을 때 처리법 (4) | 2018.04.12 |

| nvcc --Version 업데이트 및 torch, pytorch 설치시 nvcc 오류 (0) | 2017.09.28 |

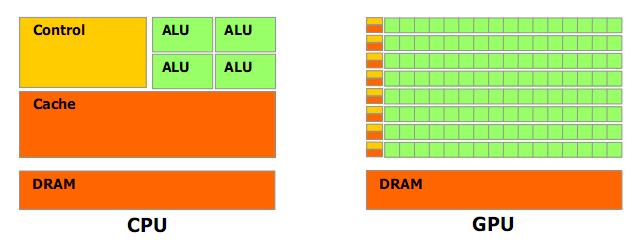

| CUDA (쿠다) 란, 왜 사용하는 것인가. (0) | 2017.03.14 |

| CUDA 란? (0) | 2017.03.14 |